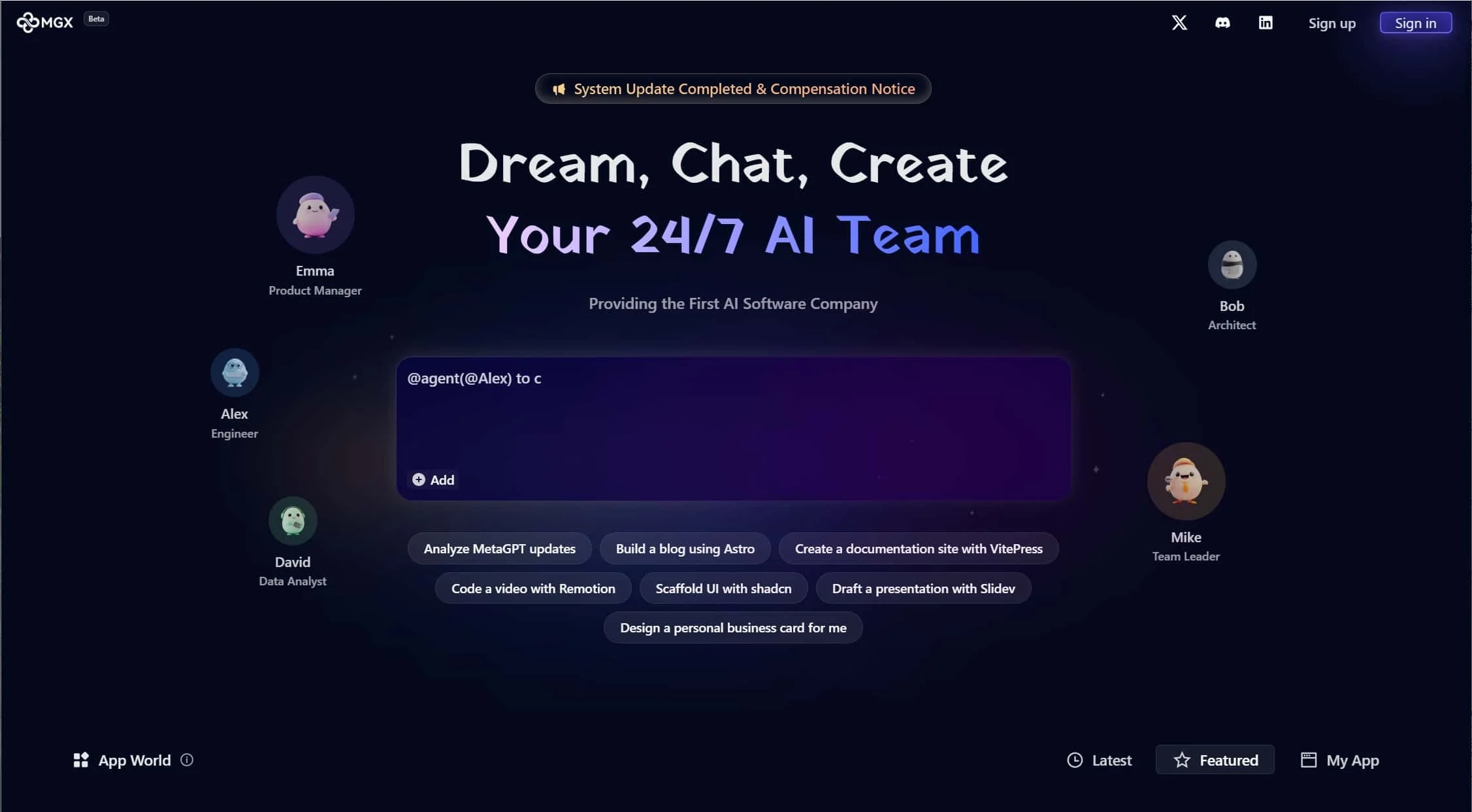

1. MGX是什么?

MGX(Model Graph eXecution)是由AI基础设施团队推出的分布式AI模型编排框架,专注于解决复杂场景下的多模型协同问题。它通过可视化工作流设计,将LLM(大语言模型)、CV(计算机视觉)模型、数据分析模型等连接为可执行的推理流水线,适用于需要多模态协作的AI应用开发。

2. 核心功能与优势

- 多模型混合编排:支持GPT-4、Stable Diffusion、PyTorch/Caffe模型等异构模型统一调度。

- 低延迟推理优化:自动分配计算资源(CPU/GPU/TPU),优化模型间数据传输效率。

- 企业级特性:

- 版本控制:跟踪模型及流水线版本变更,支持快速回滚。

- 监控告警:实时监测推理延迟、错误率等关键指标。

- 权限隔离:按团队/项目划分资源访问权限。

- 云边端部署:支持Kubernetes集群、边缘设备及混合云部署。

3. 应用场景

- 智能客服增强:结合LLM(对话)+语音合成(TTS)+情感分析模型,打造拟人化服务。

- 内容审核系统:串联图像识别(NSFW检测)+文本过滤(敏感词)+风险评级模型。

- 工业质检:协调视觉检测(缺陷识别)+数据分析(良率预测)+告警推送模型。

4. 如何使用MGX?

- 图形化编排器:拖拽模型节点并配置输入输出映射关系。

- SDK集成:通过Python/Java API调用已有流水线。

- 关键步骤:

- 注册模型(上传或连接在线API)。

- 设计DAG(有向无环图)定义执行顺序。

- 压力测试并部署为RESTful服务。

5. 对比传统开发的优势

传统多模型系统需手动处理协议转换、资源竞争等问题;MGX通过统一编排框架,减少70%的集成代码量,且内置故障转移与弹性扩缩容机制。

总结:

MGX以“模型即服务”理念重构AI工程化流程,为金融、制造、互联网等行业提供开箱即用的复杂AI系统搭建方案,是规模化落地多模态AI应用的基础设施级工具。

📢 免责声明 | 工具使用提醒

1️⃣ 本文内容基于发布时已知信息整理,AI技术及工具更新频繁,请以官方最新说明为准。

2️⃣ 推荐工具经过基础筛选,但未进行深度安全验证,请自行评估适用性及风险。

3️⃣ 使用第三方AI工具时,请注意数据隐私保护,避免上传敏感信息。

4️⃣ 本网站不承担因工具误用、技术故障或内容偏差导致的直接/间接损失。

5️⃣ 部分工具可能涉及付费订阅,请理性决策,本站不含任何投资建议。